在往期我也分享过图片生成视频的文章和工具,但这次分享与以往不同,上次分享的是需要魔法上网而且是在Discord里使用,主要是人物整体变为动态,而这次的AI技术的重点是将人物头像图片转换成具有说话功能的视频,这个非常有趣。我先来一个演示。

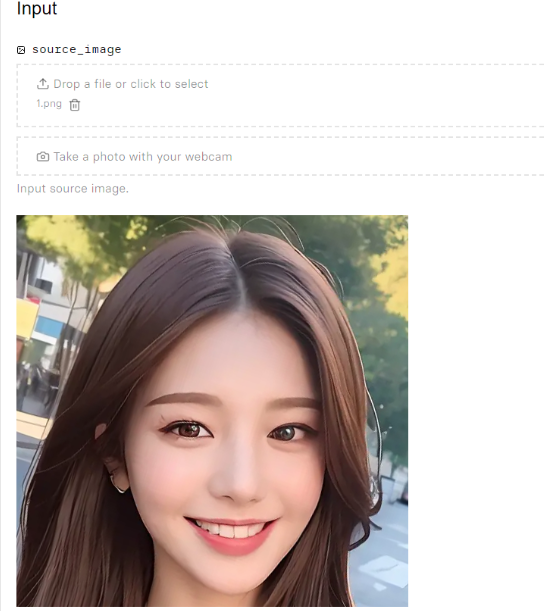

原始图片

做好的视频

这里放不了视频,可以在文章后面打开原文链接查看。

如果看过,贝格之前分享的文章,就会知道,之前分享的图片转视频效果的区别。

一、操作教程

这是一个开源的项目,开源项目链接,在文章后面获取;

如果按照开源项目的环境搭建方式,操作比较复杂,对于初学者可能会觉得门槛较高。大部分伙伴可能不愿意去尝试这么复杂的教程。不过,别担心,我找了一个可以演示的地址了。

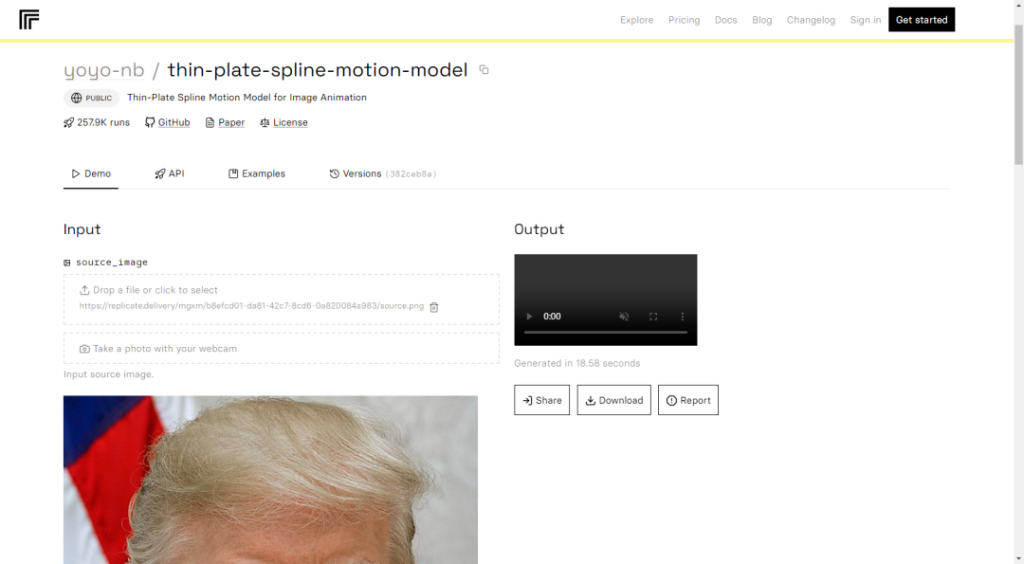

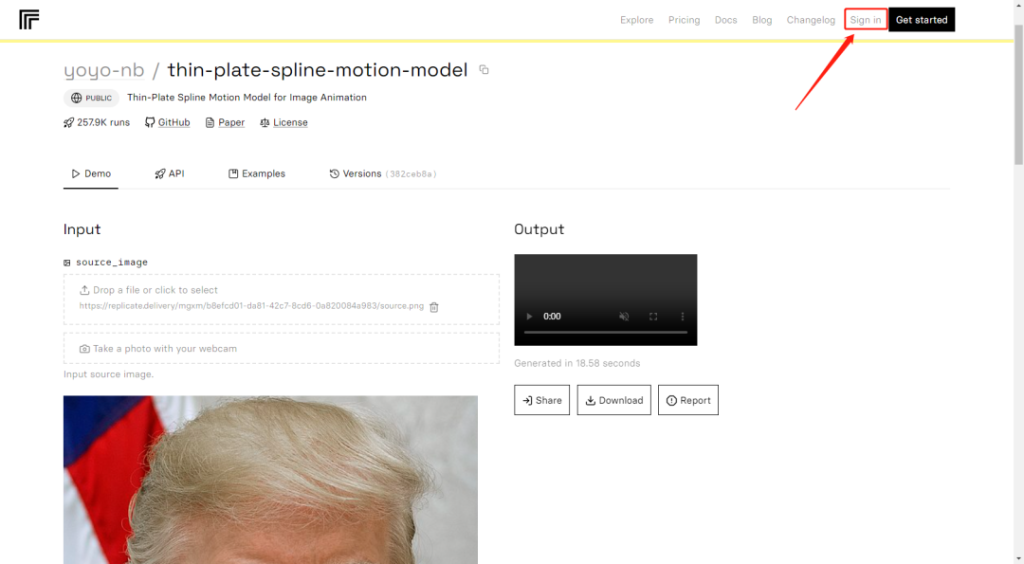

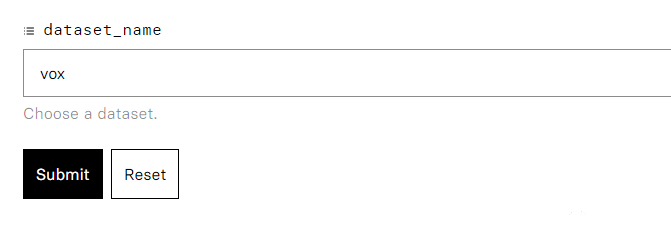

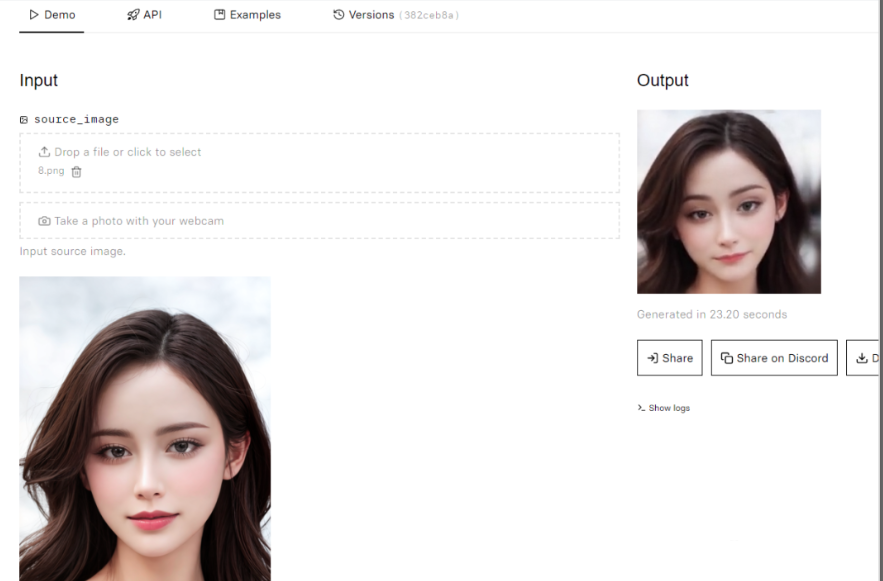

1、打开演示网址,如下图所示,网址在文章后获取;

2、登录账号,先注册一个账号,也可以直接用谷歌账号登录,如果没有的伙伴,自已注册一下,实在不会,再联系我,如下图

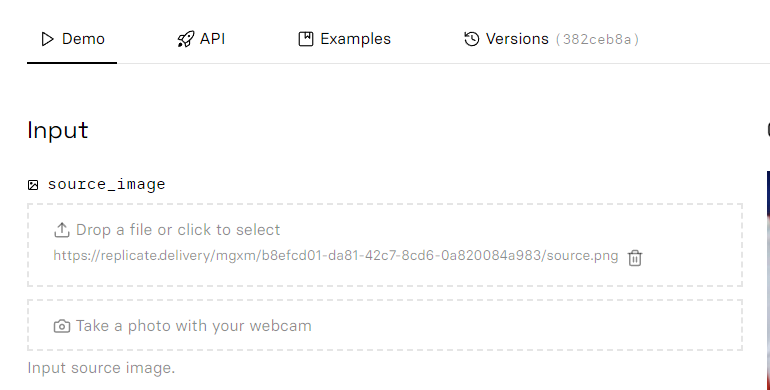

3、上传图片,如下图,

上传完成,如下图

接下来,请将网页滚动下来,然后点击提交按钮。在模型选择部分,建议保持默认设置,因为我尝试过其他模型,但效果不太好。

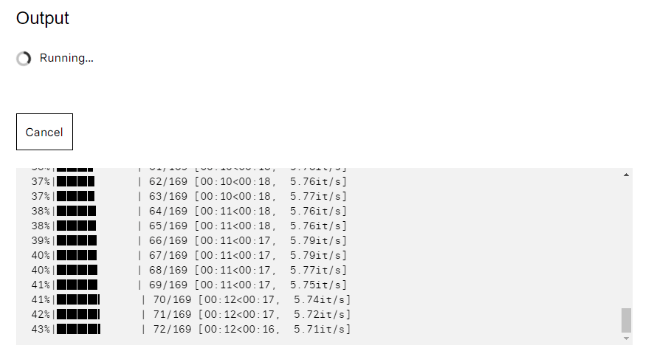

等一下片刻,

生成完成,下载保存即可

操作不是这么简单,当然,这个是搭建好的,其他的,各位伙伴,自已测试,自由发挥了。

二、工具yoyo-nb介绍

TPSM模型的核心思想是采用Thin-Plate Spline(TPS)方法进行运动估计。TPS是一种在计算机图形学和计算机视觉领域广泛应用的插值方法,能够生成灵活的光流,将源图像特征转移到目标图像特征。具体而言,TPSM模型首先通过无监督学习的方式获取源图像和目标图像中对应的特征点,然后,利用TPS方法对这些特征点进行插值,从而生成与目标图像相匹配的运动场。

Thin-Plate-Spline-Motion-Model(TPSM)是一种用于图像动画的运动模型,能够实现在源图像与目标图像之间的高度差异情况下,实现任意目标姿态的迁移。

为了更好地实现特征融合,TPSM模型还采用了一种多分辨率遮挡mask的方法。这种方法可以有效将源图像的特征信息迁移到目标图像的相应区域,同时避免特征信息混淆。此外,遮挡mask在不同分辨率下进行处理,能够更好地适应图像特征的尺度变化,从而实现更准确的运动估计。

在实际应用中,TPSM模型在各种图像动画领域广泛应用,包括人脸动画、身体姿态迁移、虚拟人物模拟等。通过该模型,我们可以将一个图像或视频中的目标姿态迁移到另一个图像或视频中,实现不同图像或视频之间的运动匹配。此外,TPSM模型还可用于动画角色的运动合成以及虚拟试衣等应用场景

三、总结

TPSM模型是一种高效的运动估计方法,可广泛应用于不同的图像动画领域。该模型的优点包括其无监督学习方法以及能够生成灵活光流的能力。未来,我们可以进一步研究该模型在其他领域的应用潜力,例如在机器人运动控制、智能视频编辑等领域的应用

开源网址:https://github.com/yoyo-nb/Thin-Plate-Spline-Motion-Model

已经搭建好链接获取方式

贝格圈公众号回复:TPS

暂无评论内容